Googleは2023年12月6日(米国時間)、新たなAIモデル「Gemini(ジェミニ) 1.0」を発表しました。

Gemini 1.0は、Googleによる最新の大規模言語モデル(LLM)。テキストやコード、音声、画像、ビデオなど、さまざまなタイプの情報を理解して組み合わせることができます。

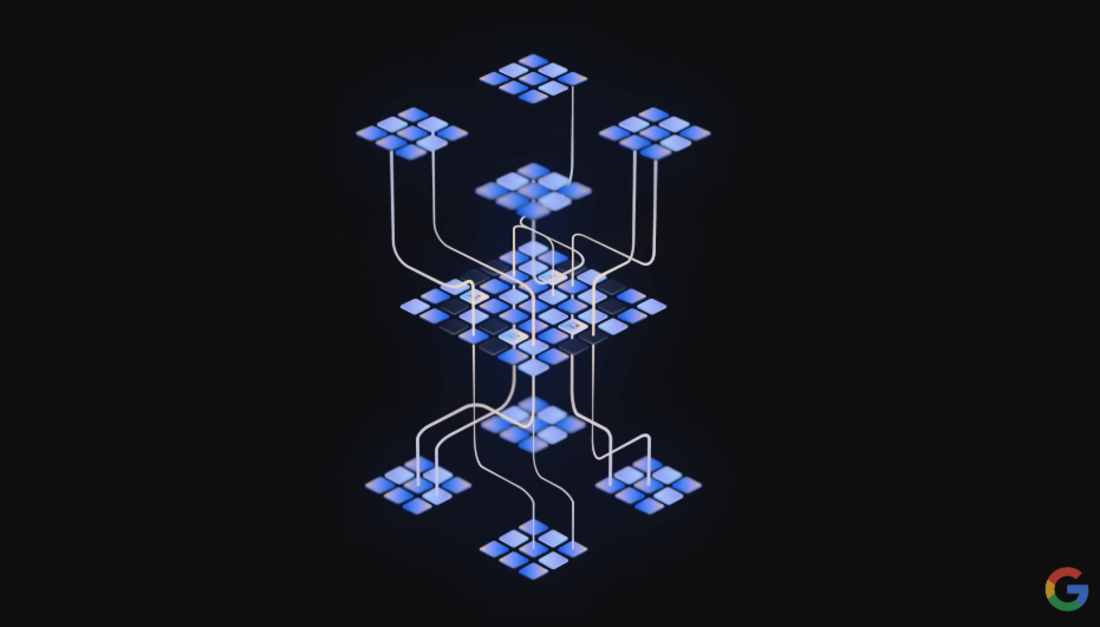

Gemini 1.0は、異なるモーダルをつなぎ合わせるのではなく、ネイティブのマルチモーダル設計となっている

これまでマルチモーダルモデルを作成する際には、異なるモダリティのために別々の要素をトレーニングし、それらをつなぎ合わせて機能の一部を大まかに模倣するのが標準的なアプローチでした。この方法で作成されたモデルは、画像を描写するといった特定のタスクを実行するのは得意でも、より概念的で複雑な推論を苦手とします。しかし、Gemini 1.0はネイティブのマルチモーダルとして設計され、最初から異なるモダリティで事前トレーニングが実施されています。そのため、従来のマルチモーダルモデルよりも、複雑な文字情報や視覚情報の理解を可能とします。

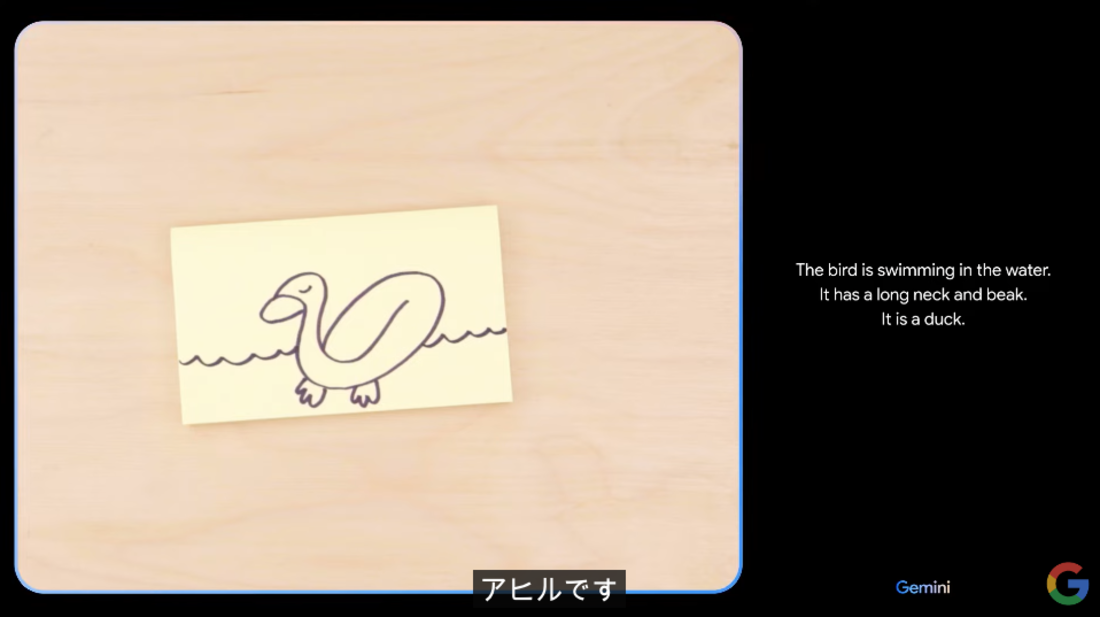

人が紙の上に描いた絵を「アヒル」と理解する

Googleの公開したGemini 1.0のデモ映像では、人が紙の上に絵を描いている状況を認識し、最終的に描き上がったものがアヒルであることを指摘しています。また、Gemini 1.0が国名クイズを出して、人が答えの国の位置を世界地図で指差すと正解・不正解を判断できているのも確認できます。Googleは、このようなテキスト・画像・音声を同時に理解し推論できる能力は、数学や物理学のような複雑な科目の推論に特に優れているとしています。

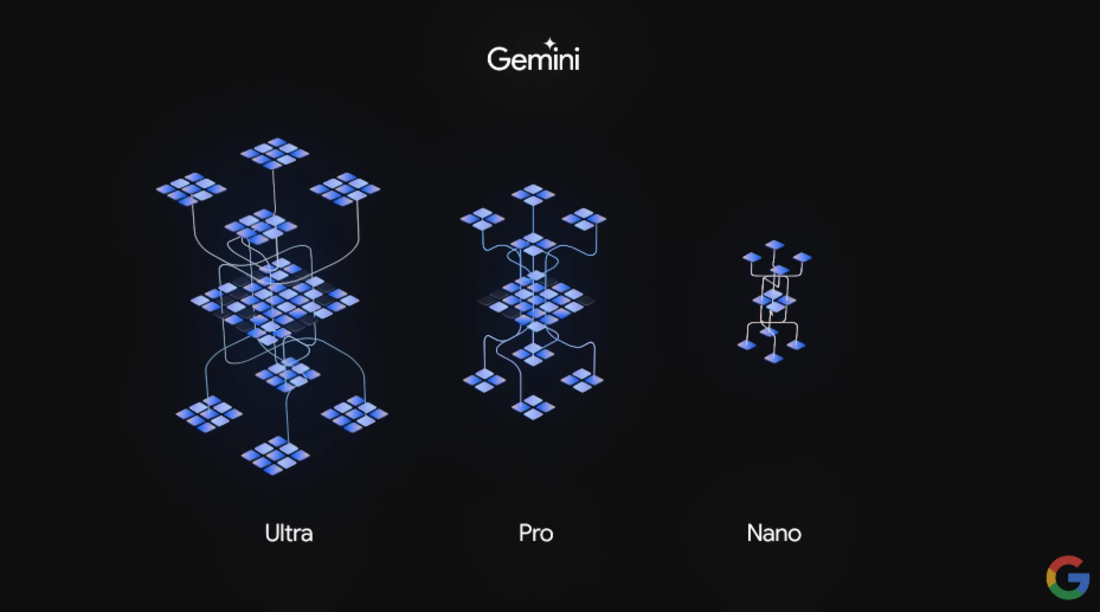

Gemini 1.0は、「Gemini Ultra」「Gemini Pro」「Gemini Nano」の3モデルで展開予定

Gemini 1.0は、「Gemini Ultra」「Gemini Pro」「Gemini Nano」の3つのモデルで展開されます。Gemini Ultraは非常に複雑なタスクに対応する最も高性能なモデルで、Gemini Proは幅広いタスクのスケーリングに最適なモデルです。Gemini Nanoは、オンデバイスタスクのための最も効率的なモデルとして用意され、Pixel 8 Proに導入されます。

Gemini 1.0は、まずGoogleのAIチャットサービス「Bard」に導入されます。Bardでは、本日よりGemini Proを微調整したバージョンが使用され、より高度な推論、計画、理解に対応します。BardへのGemini Proの導入は、Bardのリリースから最大のアップグレードだといいます。また、来年の初めには、Gemini Ultraを始めとするモデルと機能にアクセスできる「Bard Advanced」も提供される予定となっています。

Gemini Proの提供は2023年12月13日の予定で、開発者と企業顧客が対象です。Gemini Ultraは現在、微調整と人間からのフィードバックによる強化学習を実施してモデルの改良をおこなっています。早期の実験とフィードバックを実施した後に、来年の初めには開発者と企業顧客に向けて展開される予定です。