OpenAIは2023年3月14日(米国時間)、AI言語モデルの最新版「GPT-4」を発表しました。

GPT-4は、ChatGPTにも搭載されているAI言語モデルの最新バージョン。OpenAIによれば、これまでのGPT-3.5よりも、さらにクリエイティブで協力的なモデルだとのことです。GPT-4は、ChatGPTの有料プラン「ChatGPT Plus」と、アプリやサービスのデベロッパー向けのAPIで提供されます。すでにMicrosoftのWebブラウザ「Bing」では、GPT-4が導入されています。

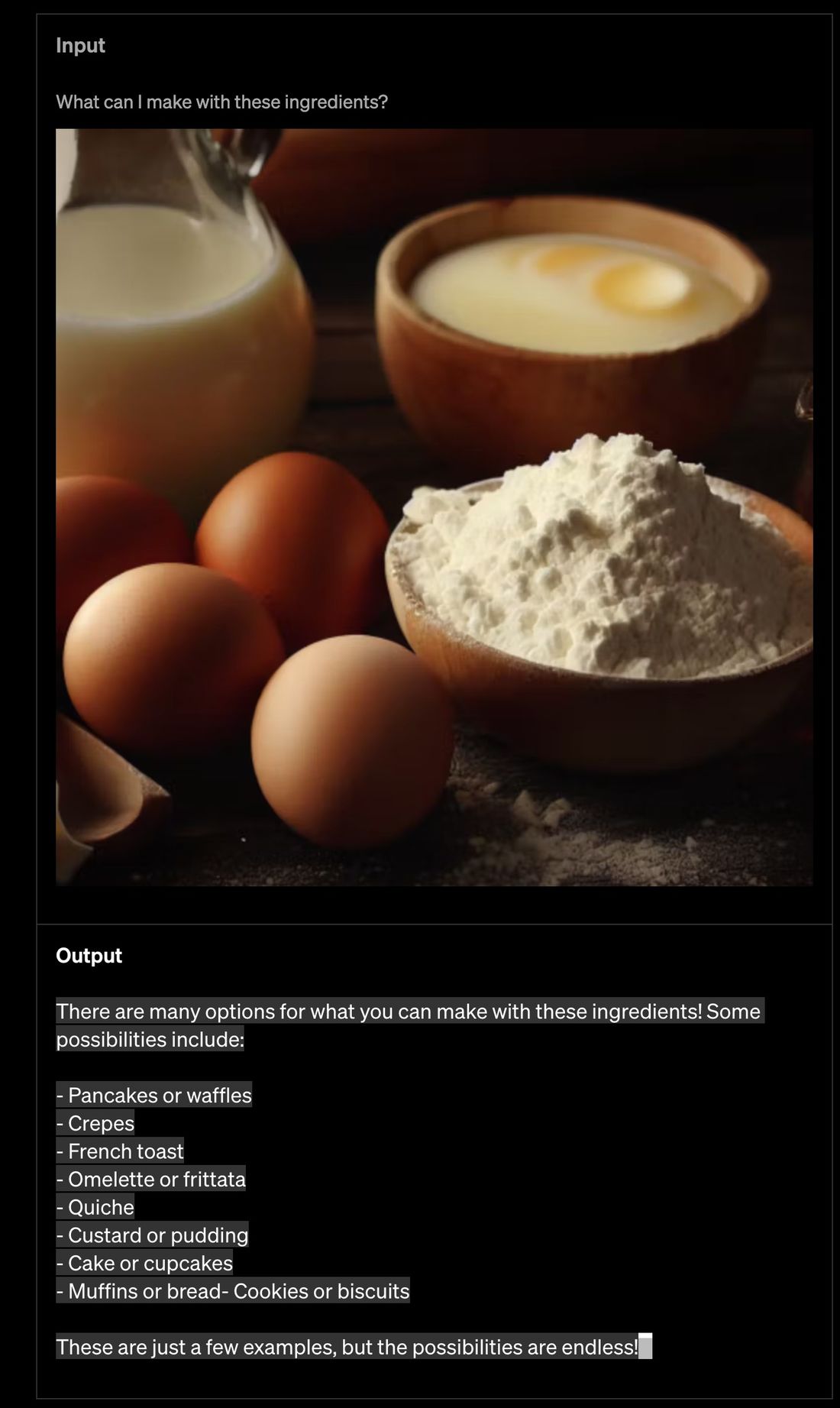

卵や小麦粉などが写った写真とともに何が作れるかを聞くと、写真に写った食材を利用する料理を回答する

GPT-4の新機能で目を引くのは、画像とテキストの同時解析への対応です。ユーザーが画像をアップロードし、画像に関する質問をすると、テキストでその質問に対する答えが出力されます。たとえば、食材の写った画像とともに「これで何が作れる?」と質問すると、画像内の食材を利用する料理を答えてくれます。従来のテキストのみの質問から聞ける内容が大きく広がり、画像内の物の名前を尋ねたり、料理の写真から逆に作り方を尋ねたりといった使い方が可能になります。ただし、画像とテキストによる質問は現時点で研究段階であるとしており、一般には公開されていません。

また、GPT-4では2万5000語以上のテキストの解析に対応します。これまでより長い論文やWebサイト、ソースコードの解析ができるようになった形です。

OpenAIの実施したテストでは、GPT-4はGPT-3.5よりも不許可コンテンツのリクエストに対応する確率が82%低く、事実に基づいた回答を出す確率が40%高かったようです。さらに、専門的・学術的分野では人間レベルの性能を発揮し、司法試験の模試では上位10%のスコアで合格したと報告しています。一方で、GPT-4でもこれまでのモデルのように、事実と異なる答えや敵対的な答えを出す問題があるとしているものの、その頻度は新モデルで改善されているとみてよいでしょう。